隨著AI、Big Data和Cloud computing的普及化,數據中心的發展迅速,數據中心網路轉發數據量越來越大,建設高性能網路會越有必要。眾所周知訓練AI模型需要使用大量GPU,然而人們普遍低估了網絡傳輸對於加速AI訓練的重要性,其中InfiniBand(IB)網絡交換機(Network Switch)是數據中心裡的一項關鍵技術,在AI服務器集群中,GPU和網絡交換機的佔比目前約7:1。今年以來,ChatGPT等語言大模型更是讓InfiniBand網絡交換機的關注度大增,這是因為他們背後使用的網絡,就是Nvidia基於IB構建的。

影響網絡速度的兩個重要因素是網絡帶寬和網絡延遲,為了有效地訓練擴展的語言模型,擁有高輸送量、低延遲的網絡可確保強大的 GPU 能夠無縫協作並處理巨大的計算工作負載。AI的網絡交換機目前主要分為兩個陣營,他們都是基於RDMA技術。一個陣營是Nvidia的InfiniBand系列交換機。另一個陣營是乙太網(Ethernet)的 RoCE。RDMA已經成為數據中心乙太網NIC和交換機的必備技術,因為RDMA能夠在佔用少量CPU資源的情況下,實現更低的延遲,能夠讓bandwidth跑滿。

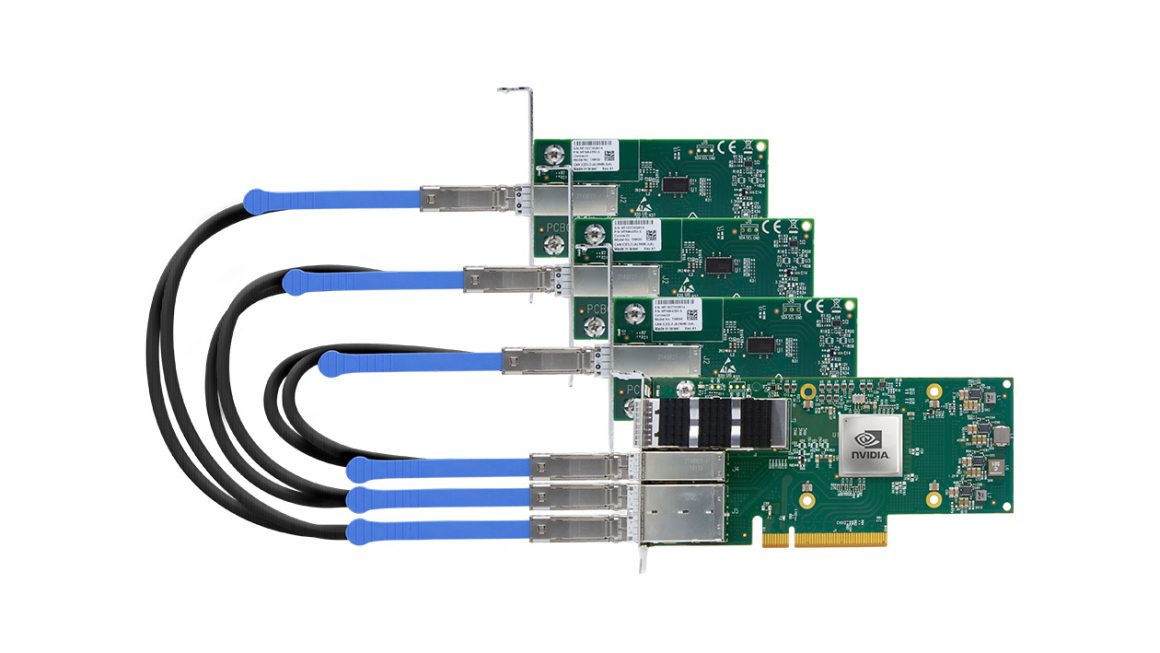

InfiniBand是一種能力很強的通信技術協議,目前超級計算機(HPC)和AI訓練最首選的內部連接技術。InfiniBand陣營裡幾乎只有被Nvidia收購的Mellanox一家獨大。目前Microsoft的GPU機器全是IB交換機。RoCE陣營裡有Arista、Cisco,而客戶則有Meta和Google,主要使用Arista的RoCE。可以說Nvidia現在憑一己之力對抗整個行業。

根據行業專家判斷,在美國,使用InfiniBand和RoCE的比例是60:40,IB稍微多一點,而在中國大陸則是70:30,同樣IB佔比較多。話雖如此,不是IB一家獨大,各大互聯網廠商都處於建立AI集群的初級階段,很有可能兩個陣營的產品都在用。

InfiniBand用戶比較多是由於IB使用RDMA作為應用層技術,是最先開始在高效能運算(HPC)紮根。由於Nvidia和InfiniBand深度捆綁,通常會與GPU捆綁一起銷售,現在GPU的供貨很緊張。客戶可能需要購買英偉達一整套方案,英偉達才會給客戶優先供應。所以使用IB的一大缺點是客戶的成本高,客戶很討厭這樣的捆綁,因為會失去談判能力,在產品的定制化、貨期、價格上都會很被動。

因此,美國今年7月底成立了超乙太網傳輸協議聯盟(UEC),該聯盟立志研發下一代RoCE,希望乙太網能夠更好為AI 集群服務。這裡面的盟友幾乎包括了所有Nvidia的競爭對手,比如Intel、AMD和Broadcom,而交換機廠商有Arista、Cisco和HPE,其使用用戶則包括Meta和Microsoft。雖然目前Microsoft使用IB交換機,加入了這個聯盟可能會被解讀成為Microsoft也在積極參與下一代RoCE的解決方案,並且以後可能會傾向使用RoCE。

最後,雖然UEC的成立希望可以在性能及競爭層面上能夠戰勝Nvidia,然而短期來仍然無辦法撼動Nvidia捆綁銷售的護城河,長期來看,有可能等到UEC把乙太網的性能超越IB,並且把其協議標準定好的時候,AI訓練的高速增長期已經過去,很多使用都已經定型了,因此長期是否能夠超越IB仍然不大確定。

簡志健,持證監會持牌人士,博立聯合創辦人/中原資產管理投資總監

傅可怡,持證監會持牌人士,博立研究團隊/中原資產管理高級分析員